NVDA 推理市場的競爭對手 - 突然爆紅的 Groq

因為 Groq LPU 的推理效能大幅優於 NVDA 的 H100, 突然之間好像就要取代 NVDA 一樣,瞬間成為 AI 產業的熱門話題,人稱「SPAC 之王」的 Chamath Palihapitiya,又身為 Groq 的早期投資人當然趁勢大打廣告,早已是獨角獸的 Groq 是否要搭著 AI 熱潮趁機上市?

【看圖書故事】

來討論一下前一陣子爆紅,但最近又比較沒聲音的 Groq;

既然聲量沒了,為什麼還要討論?

主要是因為 Groq 爆紅的主要原因之一是 Chamath Palihapitiya,在其 All in Podcast 節目上曾多次主動介紹 Groq,而 Chamath 會這麼熱心地介紹,其實是因為他自己是主要的早期投資人;

早在 2016 - 2017 年,因為 Google 首次在法說會上談論到 TPU 時,Chamath 很驚訝 Google 竟然開始在做晶片,因此想辦法與 Groq 創辦人 - Jonathan Ross 攀上關係,因此成為主要的投資人;

Chamath 既然人稱「SPAC 之王」,當然就不排除 Groq有一天會上市 IPO ,趁早熟悉他的競爭優勢與商業模式,應該也不吃虧?

不過,繼 NVDA 在 GTC24 推出 Blackwell 平台後,本月 ( 2024 年 4 月) 不僅有 Intel 推出 Gaudi 3, Google 也發表 Arm 架構的 Axion CPU 與下一代 TPU v5p,連 Meta 都接著發表新一代 的MTIA 產品。

在三連擊之後,Groq 還有機會嗎?

Chamath Palihapitiya 是誰?請看前文介紹:

《All In Podcast》 - 《SPAC 之王》與《史上十強天使投資人》

·PODCAST:https://www.allinpodcast.co/ YOUTUBE:https://www.youtube.com/channel/UCESLZhusAkFfsNsApnjF_Cg 《All In Podcast》 是一個風靡全球的投資和商業領域的節目,這個節目是由四位超級富豪主持的,每週發佈一期節目,內容涵蓋投資、科技、創業、經濟等多個方面。他們在節目中分享自己的投資觀點和經驗,討論當前的熱門話題,並提供一些有趣的投資建議。

Groq 創始人兼 CEO-Jonathan Ross

高中輟學,在 GOOGL 紐約辦事處從事廣告優化工作時,無意聽到語音辨識團隊抱怨無法獲得足夠的運算能力,當時仍是 AI 的早期階段;

他向 GOOGL 索取預算,開始組裝一個基於晶片的機器學習加速器,白天做廣告工作;晚上與加速器團隊一起工作,設計出 TPU 新晶片,並開始部署在GOOGL 資料中心,最終取得巨大成功,支撐超過 50% 的運算能力;

其他超大規模企業得知後,也試圖聘請 Jonathan Ross 建造客製化晶片,過程中,Jonathan Ross 意識到,能使用下一代運算的公司,與無法使用下一代運算的公司之間將出現差距,因此創立 Groq,著手打造一款可供所有人使用的晶片;

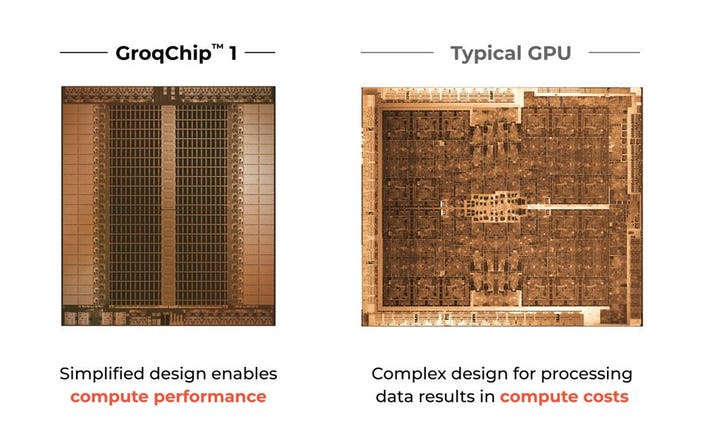

Groq 架構的核心如同一個專為機器學習設計的 ASIC,但又有別於只具備固定功能的ASIC,因為 Groq 可利用客製化的編譯器來支援不同的模型

其團隊開發多種類型的 AI 硬件,包括 LPU (Language Processing Units, GroqChip) ,可以非常高效地為 LLM 運行推理;

編譯器優先:也花很多時間在開發編譯器技術 (Groq Compiler),希望利用編譯器技術來最佳化極簡而高效能的架構,此一以編譯器為優先的設計避開複雜性,轉而追求效率,這也克服 GPU 手動編寫程式的困難;

同樣來自於 Google 的共同創辦人 - Douglas Wightman 在兩年前已經離開 Groq;

為什麼現在才爆紅?

近期出現的 LLM 跑得不夠快,GroqChip 正在解決這個問題;

幸運站上 LLM 浪潮,沒有預想到 LLM 會成為 Groq LPU 的主要應用場景, 意外發現 LPU 架構(Language Processing Unit,語言處理單元)非常適合 LLM;

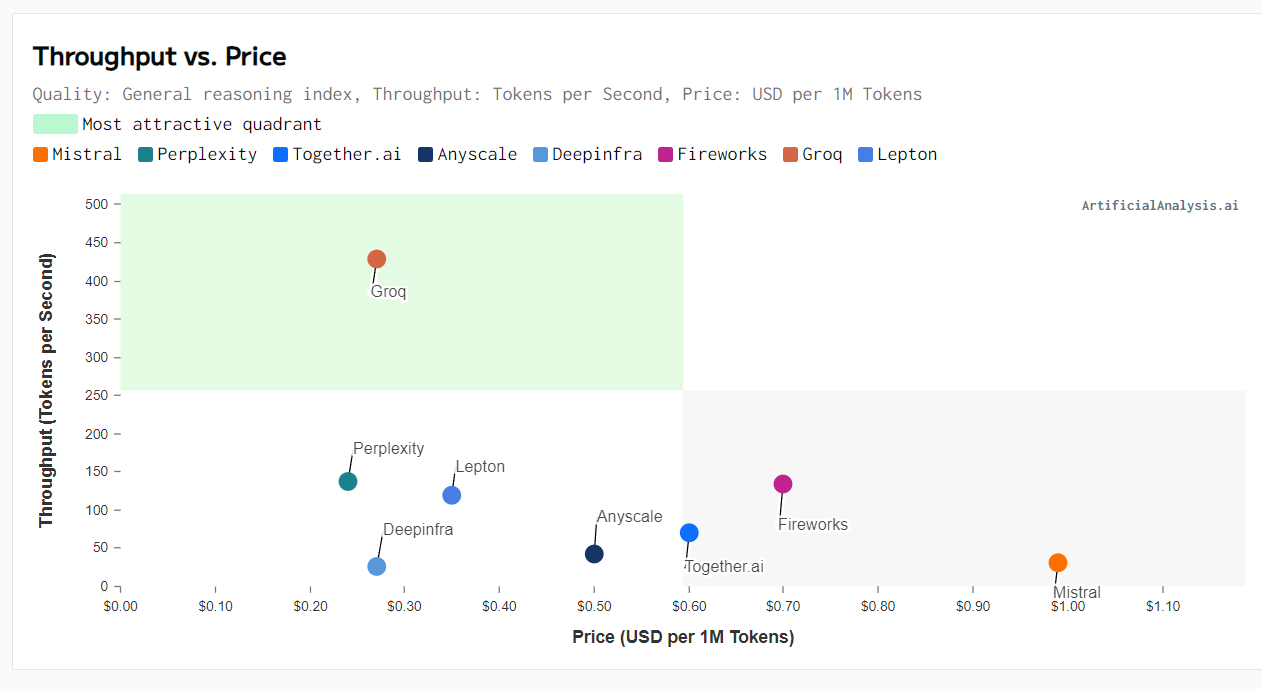

性價比是 H100 的 100 倍;

為了要展示推論能力,可以在 Groq 官網登入之後,免費使用由其 LPU所支援的推論引擎(LPU Inference Engine)的表現,

每秒可以產生 500 個 token,ChatGpt 只有 40個;

不少人將 Groq 與 ChatGPT 作比較,在兩個機器人聊天室中輸入同樣的提示,ChatGPT 花 60秒 回答問題,Groq 只花 12秒;

為什麼主攻推論市場?

AlphaGo 擊敗頂尖圍棋選手,Groq 發現 “推理”所需的運算量與 “訓練” 一樣大, 這與早期 ML 的觀點不同 (訓練需要更多運算);

AI 推理晶片 - LPU (Language Processing Units, GroqChip) ,可解決甚麼問題?

解決 GPU 和 TPU 等現有硬體,導致生成式 AI 模型速度慢、效率低的問題;

與普通 AI 不同,生成式 AI 具有順序性:下棋須依序做選擇,每個選擇影響接下來的可能性。 LLM 的每個單字的選擇都會影響下個單字的生成,需考慮上下文和邏輯順序;

現有硬體 - GPU 和 TPU 擅長平行運算:可同時處理大量獨立的任務,但不擅長處理像生成式 AI 這樣需要按順序計算的任務;

LPU 針對順序性而設計:能針對生成式 AI 的順序性進行最佳化,更有效率地處理依賴上一個結果的計算,從而提高速度和效能;

Groq 與 H100 的比較?

GroqChip LPU 不依賴 HBM 、也不依賴 TSM 的 CoWoS 封裝;

純美國製造,現在成為一種優勢;

為 LLM 推理 提供更高的吞吐量、更低的延遲和更低的成本

GroqRack:由 9 個節點組成 (通常 8 個用於計算,1 個備援;但 9 個節點在此測試都用於計算) ,共連接 574 塊 GroqChips ( 8 個機架 * 9 節點 * 8塊 GroqCard adapters)

企業要求 LLM 的推理回應時間需低於 1 秒,

Groq 表示其 LLaMA 2 推理速度,是 NVDA HGX ( 8*H100) (訓練為主,偶爾推理) 的 10 倍,性價比是100 倍

Groq 推理時間僅 HGX 的 1/10 的時間,但耗費 1/10 的能源 (1-3焦耳 vs. 10 - 30 焦耳),性價比提升 100 倍;

LLaMA 2 使用 512 個 token 輸入、1024 個 token 輸出,採用 INT8 處理

為什麼 GPU 很難手動編寫程式?

並行性:要求工程師須考慮到程式的數據依賴性,並避免數據競爭

記憶體層級:要求工程師須考慮到程序的記憶體訪問模式,並採取措施提高效率

指令集:擁有大量並行計算核心,編程模型和指令集比 CPU 更為複雜,要求工程師須了解 GPU 的硬體架構,並編寫出能夠充分利用 GPU 硬體資源的程式

為簡化 GPU 編程,各大廠商都提供自己的 GPU 編程框架,例如 NVIDIA 的 CUDA 和 AMD 的 HIP。

CUDA 和 HIP 都提供一系列的工具和程式庫,可幫助工程師更輕鬆地編寫 GPU 程序。

GroqChipGroq 的未來發展?

目前 40 個機架已經分配完畢,內部正激烈討論如何向客戶分配硬體

兩年內,Groq 將部署 100 萬顆 AI 推理晶片 - LPU (Language Processing Units, GroqChip)

由 GlobalFoundries 生產的 14 奈米 GroqChips 可透過光學互連擴展至 264 顆晶片 ( Switch 可進一步擴展,但會增加延遲),使用 SRAM,而非 HBM,這是項優勢,因為不必受限於 SK 海力士和美光 的產能,以及不用跟 NVDA 搶貨;

2025 年將推出下一代 GroqRack 系統;

由三星製造的 4 奈米的 GroqChips 可擴展到 4,128 顆;(從現在的 14 奈米升級為 4 奈米,效能將大幅提升)

2024 年需要 576 個 GroqChips 才能完成的工作,2025 年只需要 2 個機架、100 個 GroqChips 就能完成;

【看圖說故事】下面的計算是來自於 X (Twitter),都是假設,並非實際營運成本,主要是因為 Groq 尚未公布實際數據;

下面的計算,也未考慮到:

在評估 性能/總體擁有成本(TCO)時,還必須考慮硬體上同時提供服務的使用者數量;

硬體的成本,不等於服務供應商的成本;

NVDA:H100 的通用性、模型與軟體;

Groq:2萬美元是牌價;高吞吐量的優勢、同時間可以服務的客戶數、每秒產出的 Token、 Token per $;

Capex + Opex:Groq 是 H100 的 30 倍,所以 Groq 每秒產出的 Token 只要 是 H100 的 30 倍就算划算了?

GroqChip 成本? (營運分析,以 LLaMA 70b 模型為例)

每張 Groq 卡的記憶體為 230MB:假設 INT8 對記憶體的消耗,最少需 305 張卡。但 Groq 以 572 張卡做測試;

每張 Groq 卡售價 2 萬,不考慮其他情況,572 張卡成本為 1144 萬;

每卡平均功耗 185W,572塊卡的總功耗 105.8 kW;

資料中心每月每千瓦的平均價格約 $200 ,每年電費約 105. 8 * 200 * 12 = 25.4 萬

NVDA HGX (8 * H100) 性能與 572 張 Groq 相當;

HGX 最大功率為10kW,每年電費為 2.4 萬,HGX 價格約 30 萬;

營運三年

Groq:硬體採購成本為 1144 萬,營運成本為 76.2萬;

8 * H100:硬體採購成本為 30 萬,營運成本為 7.2萬;

【看圖說故事】

NVDA CEO - Jensen Huang 曾表示,目前全球幾乎所有的推論都是由其晶片所處理,而單一功能的 ASIC 的成本太高,很難滿足市場需求;

不過,Groq 也懂這個風險,因此他想成為一家同時生產自己的晶片的雲端服務供應商;

The dawn of the AI era is here, and it is crucial to understand that the cost structure of AI-driven software deviates considerably from traditional software. Chip microarchitecture and system architecture play a vital role in the development and scalability of these innovative new forms of software.

The hardware infrastructure on which AI software runs has a notably larger impact on Capex and Opex, and subsequently the gross margins, in contrast to earlier generations of software, where developer costs were relatively larger.

Consequently, it is even more crucial to devote considerable attention to optimizing your AI infrastructure to be able to deploy AI software. Firms that have an advantage in infrastructure will also have an advantage in the ability to deploy and scale applications with AI.

Google AI Infrastructure Supremacy: Systems Matter More Than Microarchitecture

Groq 的未來發展?

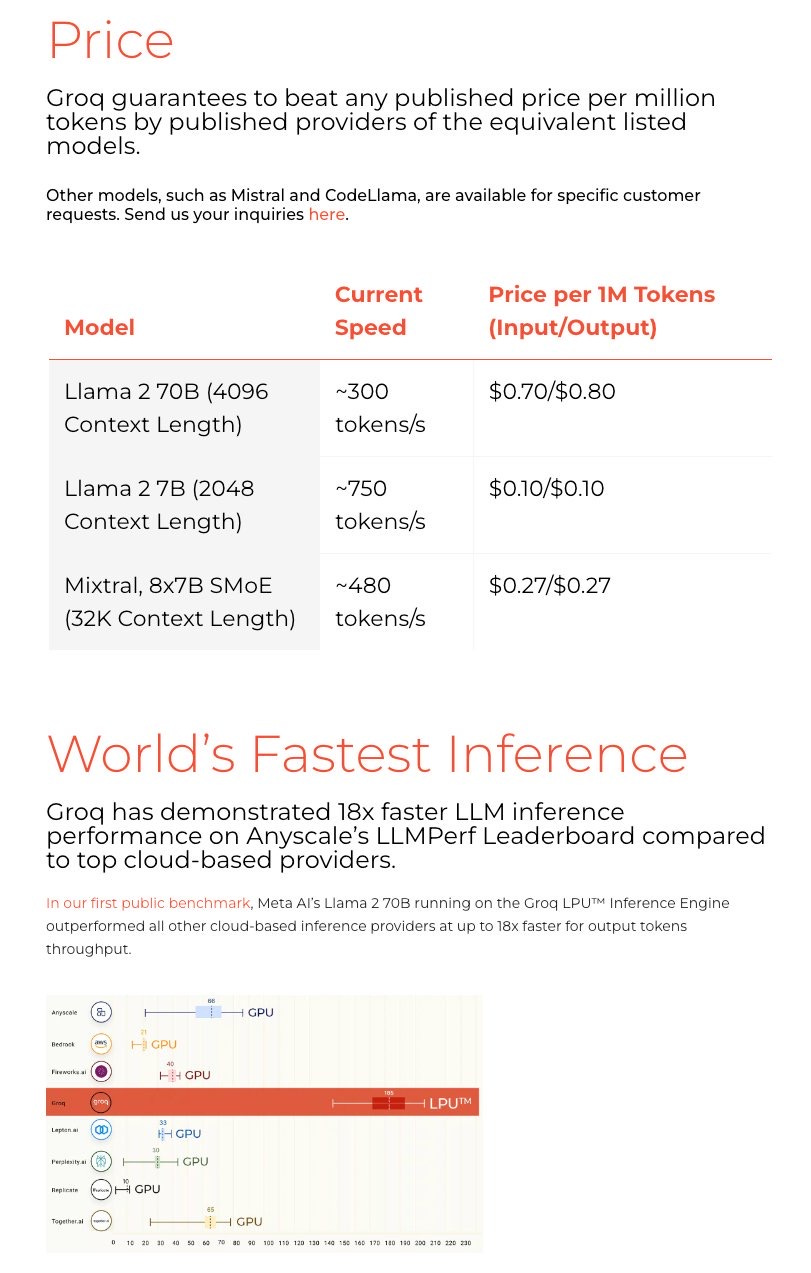

成為一家同時生產自己的晶片的雲端服務供應商;透過自己的雲端基礎設施來實現,更多的全球資料中心即將上線。(類似 NVDA 的 DGX 雲端服務)

早在 2020 年時推出當時稱為 Tensor Streaming Processor (TSP) 晶片時,就開始對特定客戶提供雲端服務;

2024 年趁著 ChatGPT 爆紅,開始讓一般消費者在 Groq 官網登入之後,就可以費使用由其 LPU 所支援的推論引擎(LPU Inference Engine);

透過 API 為希望提供對 Mistral 或 Meta 等開源模型的高速、可靠存取的第三方開發人員進行存取。

雖然目前只有 Mixtral 和Llama 2 可用,但其他模型和函式庫,包括文字轉語音產生器等音訊AI,正在積極測試並轉換為運行在 GroqChips 上。

2024 年 3 月宣布收購 Definitive Intelligence,

正式建立 GroqCloud,提供對 LPU 的按需存取。開發人員可透過該平台使用其晶片與優化後的軟體;該部門將由 Definitive Intelligence 聯合創始人兼執行長 - Sunny Madra 領導;

同時成立 Groq Systems:專注於協助政府機構等組織部署其 LPU;或為想用 LPU 建立新資料中心的組織提供服務。

【看圖說故事】

Groq 創辦人從 Google 的 TPU 出發,因了解 TPU 的不足之處,而專心做推論晶片,接著剛好搭上 ChatGPT 帶來的推論機會,趁勢推出 Groq Chip;可能也知道單做推論晶片的競爭優勢有限,所以也是從雲端來提供服務,這樣的策略可能是正確的;

因為,除了跟 NVDA 的策略類似之外,現在也可以看到各大廠都更積極的去研發 AI 的訓練與研發晶片,所以可以說幸好提早切入雲端市場?

繼 NVDA 在 GTC24 推出 Blackwell 平台後,本月 ( 2024 年 4 月) 不僅有 Intel 推出 Gaudi 3, Google 也發表 Arm 架構的 Axion CPU 與下一代 TPU v5p,連 Meta 都接著發表新一代 的 MTIA 產品;

整體看起來,Google 與 Meta 都偏向按照本身的需求去開發特定晶片 (ASIC), 像 MTIA 就是要提升 AI 效能,讓臉書和 IG 上的內容進行排名和推薦更有效率;

在三連擊之後,Groq 還有機會嗎?是不是應該要避開這些大公司、以後專注於提供推論雲端服務給沒有辦法自己研發推論晶片的中小型公司?

往好的方面想,除了 Chamath 的投資外,根據 Forbes 的報導,Groq 用 6,700 萬美元的資金已經先開發首款 AI 晶片,2021 年 C 輪又獲得來自於 Tiger Global Management 和 D1 Capital 的 3 億融資,估值至少已超過 10 億美元;

若再趁著AI 熱潮再多募點錢,或許可以提升晶片產量、壓低成本,然後擴大雲端服務,說不定可以搶到一些利基市場?

如果正式上市後,S-1 應該有更詳細的營運介紹,Groq 能不能上市,讓我們繼續看下去!

very interesting

很專業 感謝分享